メタデータ、高精度RAG製品「ChatBrid」に新機能「キャッシュ回答」を追加

~ 回答の一貫性向上・平均応答時間の短縮・LLM API費用の削減・LLMダウン時にも高頻度質問対応を同時に実現。

メタデータ株式会社(所在地:東京都文京区、代表取締役社長:野村直之)は、社内外の大規模な知識を高精度に活用できるRAGエンジン「ChatBrid(チャットブリッド)」に、過去の回答履歴を活用して同等意味の質問に即時に同一回答を返す「キャッシュ回答機能」を追加します。これにより、①回答の一貫性の大幅な向上、②平均応答時間の短縮、③LLM API費用の削減を同時に実現します。また、LLMダウン時にも過去履歴に同意味の質問があれば回答が可能です。本機能は2025年11月より提供開始予定です。

■ 背景 ~ChatBrid, ChatBridBCP

ChatBridは、2023年4月18日の初版リリース以来、質問のジャンルを自動判別し、必要十分な質と量の「影プロンプト(ユーザーに見えない隠しプロンプト)」だけを選択して、関連する知識レコード(チャンク)とともにLLMへ送信する設計としてまいりました。これにより、データやユーザー規模が拡大しても高精度を維持しながら、高速応答とAPI利用コスト削減を両立しています。ChatBrid Webアプリはスレッド単位の履歴管理を備え、シンプルで直感的な対話画面を提供しています。

また、2024年12月12日の外部LLM API障害を契機に、SaaS型LLMに過度に依存しないレジリエンスを強化。API障害時に自動で別LLMへ切り替える「ChatBridBCP(Business Continuity Planning)」を実装し、業務継続性を高めてきました。

■ 新機能「キャッシュ回答機能」の概要

「キャッシュ回答機能」は、過去の対話履歴を検索・絞り込みした結果を背景(前文脈)として活用するChatBridの強みをさらに拡張。ほぼ同じ意味の質問が来た場合、過去の回答履歴があれば、その“同一テキスト”を即座に返します。これにより、

・回答の一貫性向上:同じ問いに対して毎回表現や詳細が揺れるというLLM特有の課題を解消し、ヒット時は完全に同一の回答文を返します。

・平均応答時間の短縮:キャッシュヒット時は即時返答。実測では、質問「メタデータはどういう会社?」に対し0.29秒で6行の回答を表示。続けて「メタデータ株式会社の企業内容」と入力したケースでも、ローカル実行の軽量LLMにより0.25秒で前回と一字一句同じ回答を返しました。

・コスト削減:キャッシュヒット時には有料の外部LLM APIへアクセスせず、都度の生成コストを抑制します。(上記はRAGサンプルデータに同社紹介・規程類を登録した検証結果)

■ 「キャッシュ回答機能」のユーザーインタフェース

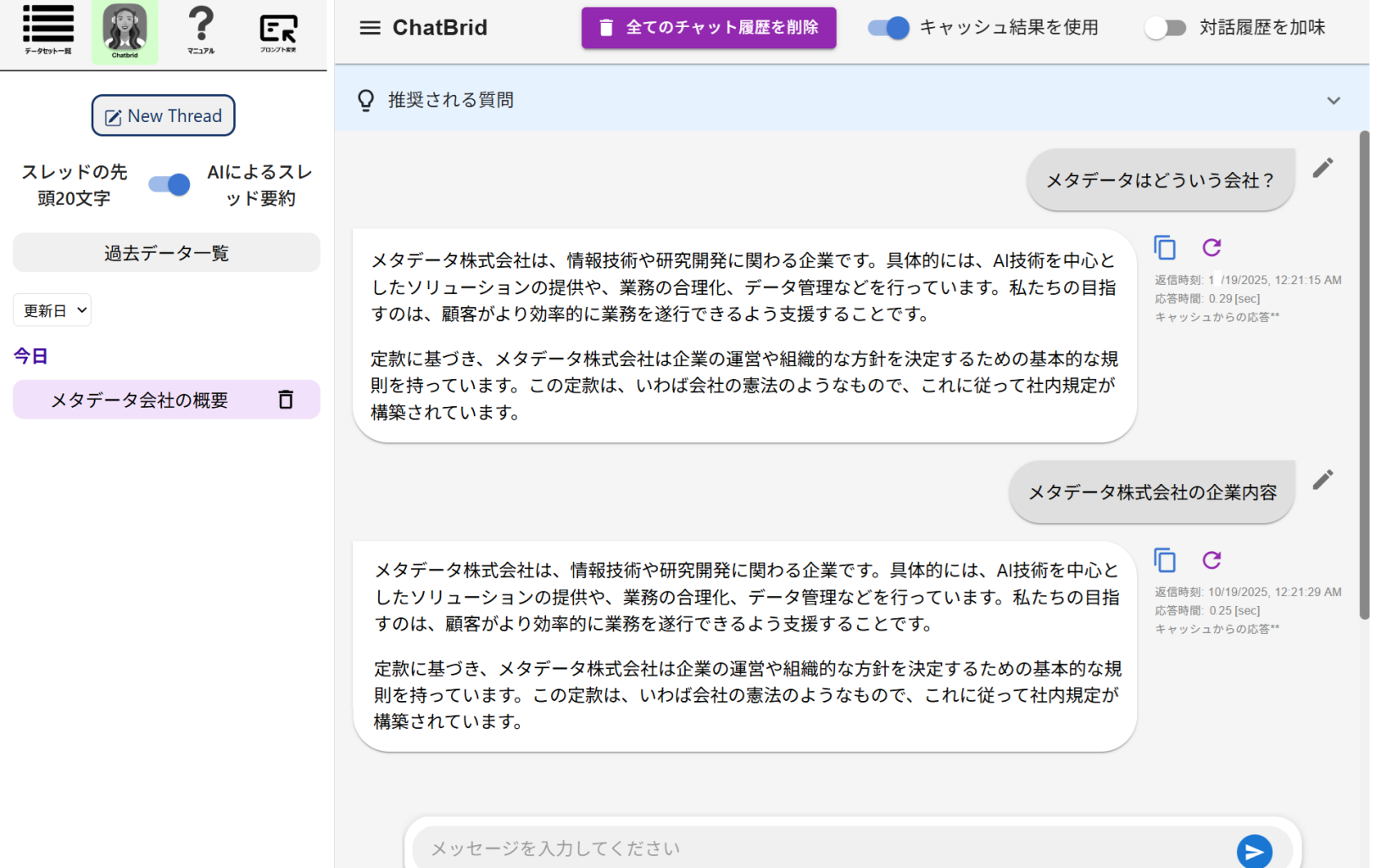

画像は、ChatBrid Webアプリの対話画面です。

RAGのサンプルデータとして、メタデータ株式会社の紹介文章や規程類を登録した状態で、まず、「メタデータはどういう会社?」という質問を投入しています。すると過去履歴にヒットしたため、0.29秒で、画面の通り、6行の回答が返ってきています。

次に、「メタデータ株式会社の企業内容」と打ち込んだところ、CPU上で動作する軽量のローカルLLMにより、0.25秒で、画面の通り、先の回答と一字一句変わらない、同一の回答が返ってきています。

この際に、OpenAI社などの有料LLM APIにアクセスしていません。このため、先述の通り、応答速度が「速い」、LLM利用料が「安い」、過去の回答との完全な一貫性を保てているという意味で「旨い」というまるで牛丼のキャッチフレーズのようなメリットが実現しています。

■「キャッシュ回答機能」のユースケース例

- 社内Q&Aの標準化:規程・手順・福利厚生など、社内で頻出する“意味が同じ”問い合わせに対し、常に同一の公式回答を返し、ナレッジの齟齬を防止。

- 顧客サポートのSLA強化:FAQ相当の質問はキャッシュで高速応答し、新規質問への回答の妥当性評価等に知識サポートのコストを集中。

- 障害・ピーク時の耐性向上:代替LLM非保有時でも、過去に同等問合せがあれば即時返答でき、サービス継続性に寄与。

■ 提供開始時期

- 2025年11月